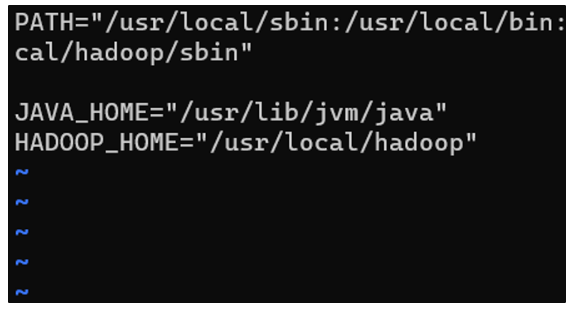

인스턴스(컨테이너) 복제가 완료되었으니 Zookeeper 클러스터를 설정해주자. myid 파일 편집 : nn1,nn2,dn1 서버에 myid를 각각 1,2,3으로 편집 # nn2 서버에서 vim /usr/local/zookeeper/data/myid # 아래 내용으로 수정 후 저장 2 # nn1으로 이동 exit # dn1 서버에서 vim /usr/local/zookeeper/data/myid # 아래 내용으로 수정 후 저장 3 Zookeeper 실행 : nn1, nn2, dn1 서버에서 각각 실행한다. # nn1 서버 zookeeper 시작 /usr/local/zookeeper/bin/zkServer.sh start # nn2 서버 zookeeper 시작 /usr/local/zookeeper/bin/z..